近期文章:使用 ansible 一键安装kubernetes+containerd+calico集群

在docker中可以对容器应用程序的资源进行限制,通过cgroup来控制容器,以确保它们在运行时不会占用过多的系统资源。以下是一些常见的 Docker 资源限制选项

- 内存限制:可以使用

--memory或-m选项来限制容器可以使用的内存。例如,--memory=1g表示限制容器使用的内存为 1GB。超出限制的内存使用可能会导致容器被终止或无法正常运行。 - CPU 限制:可以使用

--cpus选项来限制容器可以使用的 CPU 核数。例如,--cpus=0.5表示限制容器使用的 CPU 核心为 0.5 个。这个值可以是小数,表示分配的 CPU 资源的相对权重。 - CPU 调度策略:可以使用

--cpu-shares选项来为容器分配 CPU 时间片的权重。这个值越高,容器获得的 CPU 时间越多。默认情况下,所有容器的 CPU 权重相等。 - IO 限制:你可以使用

--blkio-weight选项来设置容器对 IO 资源的相对权重。默认情况下,所有容器的 IO 权重相等。 - 网络带宽限制:可以使用

--network选项来限制容器的网络带宽。例如,--network=none表示容器没有网络访问权限,--network=host表示容器与宿主机共享网络。

docker 内存限制

Docker提供参数-m, –memory=””限制容器的内存使用量。

案例1:允许容器使用的内容从上限为1024M:

[root@master ~]# docker run -it -m 1g centos [root@b178d97e0992 /]# cat /sys/fs/cgroup/memory.max 1073741824 #这里显示的是字节,换算后是1G

当容器超过这个限制时,可能会被终止或无法正常运行

docker cpu核数限制

参数:–cpuset可以绑定CPU

对多核CPU的服务器,docker还可以控制容器运行限定使用哪些cpu内核和内存节点,即使用–cpuset-cpus和–cpuset-mems参数。对具有NUMA拓扑(具有多CPU、多内存节点)的服务器尤其有用,可以对需要高性能计算的容器进行性能最优的配置。如果服务器只有一个内存节点,则–cpuset-mems的配置基本上不会有明显效果

扩展:

服务器架构一般分: SMP、NUMA、MPP体系结构介绍

从系统架构来看,目前的商用服务器大体可以分为三类:

- 即对称多处理器结构(SMP : Symmetric Multi-Processor) 例: x86 服务器,双路服务器。主板上有两个物理cpu

- 非一致存储访问结构 (NUMA : Non-Uniform Memory Access) 例: IBM 小型机 pSeries 690

- 海量并行处理结构 (MPP : Massive ParallelProcessing) 。 例: 大型机 Z14

docker CPU调度策略

#查看配置份额的帮助命令: [root@master data]# docker run --help | grep cpu-shares -c, --cpu-shares int CPU shares (relative weight)

CPU shares (relative weight) 在创建容器时指定容器所使用的CPU份额值。cpu-shares的值不能保证可以获得1个vcpu或者多少GHz的CPU资源,仅仅只是一个弹性的加权值。

默认每个docker容器的cpu份额值都是1024。在同一个CPU核心上,同时运行多个容器时,容器的cpu加权的效果才能体现出来

例: 两个容器A、B的cpu份额分别为1000和500,结果会怎么样?

情况1:A和B正常运行,占用同一个CPU,在cpu进行时间片分配的时候,容器A比容器B多一倍的机会获得CPU的时间片。

情况2:分配的结果取决于当时其他容器的运行状态。比如容器A的进程一直是空闲的,那么容器B是可以获取比容器A更多的CPU时间片的; 比如主机上只运行了一个容器,即使它的cpu份额只有50,它也可以独占整个主机的cpu资源。

cgroups只在多个容器同时争抢同一个cpu资源时,cpu配额才会生效。因此,无法单纯根据某个容器的cpu份额来确定有多少cpu资源分配给它,资源分配结果取决于同时运行的其他容器的cpu分配和容器中进程运行情况。

例1:给容器实例分配512权重的cpu使用份额

参数: -c 512 [root@master data]# docker run -it -c 512 centos /bin/bash [root@bae4e42c30f0 /]# cat /sys/fs/cgroup/cpu/cpu.shares #查看结果 512 总结: 通过-c设置的 cpu share 并不是 CPU 资源的绝对数量,而是一个相对的权重值。某个容器最终能分配到的 CPU 资源取决于它的 cpu share 占所有容器 cpu share 总和的比例。通过 cpu share 可以设置容器使用 CPU 的优先级

docker 测试cpuset-cpus和cpu-shares

测试cpuset-cpus和cpu-shares混合使用运行效果,就需要一个压力测试工具stress来让容器实例把cpu跑满。 当跑满后,会不会去其他cpu上运行。 如果没有在其他cpu上运行,说明cgroup资源限制成功

运行两个容器实例

[root@master ~]# docker run -itd --name docker10 --cpuset-cpus 0,1 --cpu-shares 512 centos /bin/bash d9474b41882704420ede69c40f7b8c7a548d7fca988f86287838fa65f2d8491c [root@master ~]# docker run -itd --name docker20 --cpuset-cpus 0,1 --cpu-shares 1024 centos /bin/bash 14b95ad48ddb106c9196e68fe07fab1c52c2a3032a7839336c8245d27803db38

测试1: 进入容器docker10,使用stress测试进程是不是只在cpu0,1上运行:

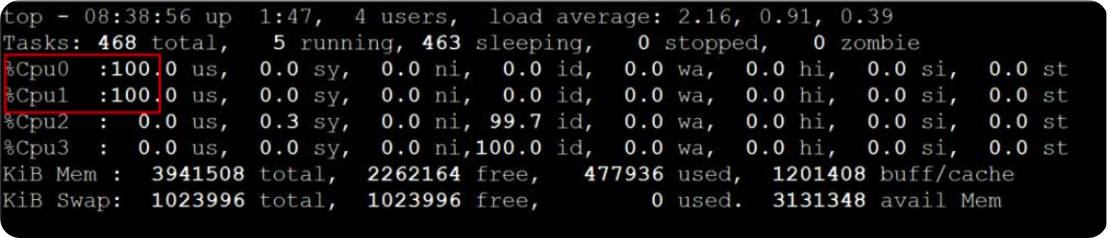

[root@master ~]# docker exec -it docker10 /bin/bash [root@master ~]# rm -rf /etc/yum.repos.d/* [root@d9474b418827 ~]# curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-vault-8.5.2111.repo [root@d9474b418827 /]# yum install -y epel-release [root@d9474b418827 /]# yum install -y stress stress参数解释 -? 显示帮助信息 -v 显示版本号 -q 不显示运行信息 -n 显示已完成的指令情况 -t --timeout N 指定运行N秒后停止 --backoff N 等待N微妙后开始运行 -c 产生n个进程 :每个进程都反复不停的计算随机数的平方根,测试cpu -i 产生n个进程 :每个进程反复调用sync(),sync()用于将内存上的内容写到硬盘上,测试磁盘io -m --vm n 产生n个进程,每个进程不断调用内存分配malloc()和内存释放free()函数 ,测试内存 --vm-bytes B 指定malloc时内存的字节数 (默认256MB) --vm-hang N 指定在free栈的秒数 -d --hadd n 产生n个执行write和unlink函数的进程 -hadd-bytes B 指定写的字节数 --hadd-noclean 不unlink 注:时间单位可以为秒s,分m,小时h,天d,年y,文件大小单位可以为K,M,G [root@d9474b418827 /]# stress -c 2 -v -t 10m #运行2个进程,把两个cpu占满,在物理机另外一个虚拟终端上运行top命令,按1快捷键,查看每个cpu使用情况: [root@d9474b418827 /]# top top - 08:09:16 up 18 min, 0 users, load average: 2.22, 1.48, 0.78 Tasks: 6 total, 1 running, 2 sleeping, 3 stopped, 0 zombie %Cpu0 :100.0 us, 0.0 sy, 0.0 ni, 0.0 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st %Cpu1 :100.0 us, 0.0 sy, 0.0 ni, 0.0 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st %Cpu2 : 3.1 us, 1.7 sy, 0.0 ni, 95.1 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st %Cpu3 : 3.5 us, 1.8 sy, 0.0 ni, 94.7 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st MiB Mem : 1819.2 total, 142.3 free, 813.7 used, 863.2 buff/cache MiB Swap: 0.0 total, 0.0 free, 0.0 used. 842.9 avail Mem #可看到正常。只在cpu0,1上运行

测试2

然后进入docker20,使用stress测试进程是不是只在cpu0,1上运行,且docker20上运行的stress使用cpu百分比是docker10的2倍

[root@d9474b418827 /]# docker exec -it docker20 /bin/bash [root@14b95ad48ddb /]# stress -c 2 -v -t 10m

注:两个容器只在cpu0,1上运行,说明cpu绑定限制成功。而docker20是docker10使用cpu的2倍。说明–cpu-shares限制资源成功。

docker IO限制

[root@master ~]# docker run --help | grep write-b

--device-write-bps list Limit write rate (bytes per second) to a device (default [])

#限制此设备上的写速度(bytes per second),单位可以是kb、mb或者gb。

[root@master ~]# docker run --help | grep read-b

--device-read-bps list Limit read rate (bytes per second) from a device (default [])

#限制此设备上的读速度(bytes per second),单位可以是kb、mb或者gb

情景:防止某个 Docker 容器吃光你的磁盘 I / O 资源

例1:限制容器实例对硬盘的最高写入速度设定为 2MB/s。

–device参数:将主机设备添加到容器

[root@master ~]# mkdir -p /var/www/html/ [root@master ~]# docker run -it -v /var/www/html/:/var/www/html --device /dev/sda:/dev/sda --device-write-bps /dev/sda:2mb centos /bin/bash [root@e3f881a065b0 /]# time dd if=/dev/sda of=/var/www/html/test.out bs=2M count=50 oflag=direct,nonblock

注:dd 参数:

direct:读写数据采用直接IO方式,不走缓存。直接从内存写硬盘上。

nonblock:读写数据采用非阻塞IO方式,优先写dd命令的数据

50+0 records in

50+0 records out

104857600 bytes (105 MB, 100 MiB) copied, 50.0085 s, 2.0 MB/s

real 0m50.018s

user 0m0.000s

sys 0m0.089s

注: 发现1秒写2M。 限制成功

docker 网络带宽限制

这个很少用,就不赘述了